线性代数要旨(二)

之前学习线性代数也刷了不少遍了,最近又频繁用到,发现理解的还是不够深,把之前写的笔记翻出来汇总一下。

线性代数要旨(一)线性方程组/矩阵代数/行列式

线性代数要旨(二)向量空间/特征向量/正交性/最小二乘法/二次型

线性代数要旨(三)线代四大基本定理/可逆矩阵定理

ch4 向量空间 ‘线性代数及其应用笔记’

具体数学

4.1 向量空间与子空间

向量空间

一个向量空间是有一些被称为向量的对象构成的非空集合V,在这个集合上定义两个运算,称为加法和标量乘法(标量取实数),服从以下法则,这些法则必须对所有向量u,v,w及所有标量c和d均成立。

1. u,v之和u+v仍在V中

2. u+v=v+u

3. (u+v)+w=u+(v+w)

4. V中存在一个零向量0,使u+0=u

5. 对V中每个向量u,存在V中向量-u,使得u+(-u)=0

6. u与标量C的标量乘法记为cu,仍在V中

7. c(u+v)=cu+cv

8. (c+d)u=cu+du

9. c(du)=(cd)u

10. 1u=u

子空间

向量空间的一个子空间是V的一个满足以下三个性质的子集:

1. V的零向量在H中

2. H对向量加法封闭

3. H对标量乘法封闭

取向量空间V中一些向量 ,则 是V的一个子空间,称 是由 生成的子空间。

4.2 零空间,列空间和线性变换

零空间

的矩阵A零空间写作NulA ,是齐次方程Ax=0的全体解的集合。

零空间是 的一个子空间。

列空间

矩阵的列空间是由A的列的所有线性组合组成的集合,若 ,则

零空间也是 的一个子空间。

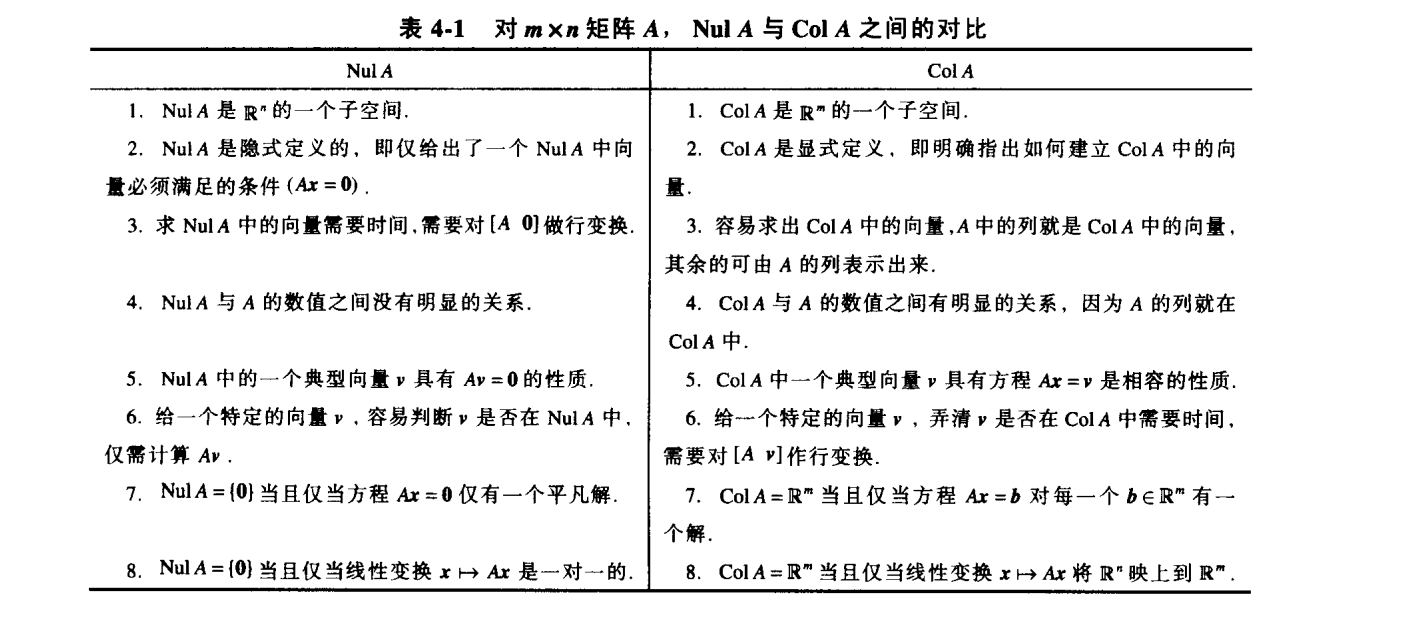

Attention 如果一个矩阵不是方阵,它的零空间和列空间在完全不同的域, 矩阵列空间在 ,零空间在 。

1.1.png-163.9kB

1.1.png-163.9kB

我们用线性变换描述 以外的向量空间的子空间。

线性变换

由向量空间V映射到向量空间W内的线性变换T是一个规则,实现V到W的单射,其满足:

1. T(u+v)=T(u)+T(v)

2. T(cu)=cT(u)

线性变换T的核(或零空间)是V中所有满足T(u)=0的向量u的集合,值域指W中所具有形式T(x)的向量的集合。

4.3 线性无关集和基

令H是向量空间V的一个子空间,V中的向量的指标集 称为H的一个基,当且仅当:

1. B是一线性无关集

2.

一个基是一个不包含不必要向量的高效率生成集,可以通过去掉一个生成集中不需要的向量构造出来。

生成集定理

若 是V中向量集,

则有

1. 去掉S中某一可以用其他向量线性组合表示的向量,S仍然可以生成H。

2. 若 ,则S的某一子集是H的基

这里我们讲一下如何求零空间和列空间的基。

- 零空间,解除Ax=0,将自由变量提出作为权,剩下的就是基

- 列空间,矩阵A初等行变换至阶梯形矩阵B,然后我们就知道B的主元列是哪些,对应的A的主元列就是一组基(这里再次强调初等行变换后得到的列完全不同,但是列之间的线性相关关系不变|就像你大爷名字从小明改成小红,但是你大爷还是你大爷)。换言之,我们利用B来去除不必要的生成集元素。

基是最大的线性无关集和最小生成集。

4.4 坐标系

搞基指定基的原因就是为空间建一个坐标系。最著名的就是笛卡尔坐标和 的基情了。有了坐标系,任何向量空间V都可以像 一样便于操作。

唯一性标识表示

B是V的一组基,则V中每个向量存在唯一一组数 使得

向量

4.5向量空间的维数

定理:

- 若向量空间V具有一组基 ,则V中任意包含多余n个向量的集合一定线性相关。

- 若向量空间V中有一组基含有n个向量,则V的每一组基必都有n个向量。

维数

若V由一个有限集生产,则称V为有限维的,V的维数写成dimV,是V的基中含有向量的个数,零向量空间维数为0。若V不是由一有限集生成,则称V为无穷维的。

有限维空间的子空间

H是有限维向量空间V的子空间,则H也是有限维向量空间,且

这样我们很容易就可以得到基定理: V是p维向量空间, ,V中任意含有p个元素的线性无关集必定是V的一个基。任意含有p个元素且生成V的集合必定是V的一个基。

NulA的维数是方程Ax=0中自由变量的个数,ColA的维数是A中主元列的个数。

4.6秩

行空间:矩阵A的行向量的所有线性组合的集合,记作Row A。

秩定理:

矩阵A的秩即A的列空间的维数,且等于行空间维数。秩还等于A的主元位置个数,且满足

定理

下列命题均等价于A是可逆矩阵:

1. A的列构成 的一个基

2.

3. dimCol A=n

4. rank A=n

5. Nul A={0}

6. dim Nul A=0

4.7 基的变换

设 和 都是向量空间V的基,则存在一个 矩阵 使得

P的列是基B中向量的C-坐标向量,即

称为由B到C的坐标变换矩阵。乘以P的运算把B-坐标变成C-坐标。

易证:

4.9 马尔科夫链中的应用

概率向量:具有非负分量且各分量的数值相加等于一的向量。

随机矩阵:各列向量均为概率向量的方阵。

马尔科夫链

是一个概率向量序列 和一个随机矩阵P,使得

用一阶差分方程刻画就是

通常称为状态向量

稳态向量: 向量q满足

定理: P是 n维正规随机矩阵,则P具有唯一的稳态向量q,若 是任意一个起始状态,且 ,则当 ,马尔科夫链收敛到q。

啊没错,马尔科夫链的奇妙之处就在于无论初始是什么状态,长期之后都接近稳态,这是一个数学世界里的“故事的结局早就写在开头”型爱情故事。

心得拾遗

- 矩阵乘积的秩不超过任何一个因子的秩。

- 矩阵乘法的解释多了一种吧,若 可以作为基的话,那么AB可以看成是将B中所有列向量的坐标从以标准基到以 的坐标。是呀,对象的变换本来就是相对于坐标系的,变换是相对的。

- 秩定理还有一种等价的描述

这里V指原向量空间,T指一个线性变换,该变换将V的子空间变换到W的子空间。ker(T)就是T的核,也就是V中经T变换为0的元素的集合,和之前描述中的NulA解空间是一样的。dimV就是V的维度,对于 矩阵来说也就是n。这里的rankT也可以换为dim R(T),R(T)就是V中所有元素经T变换组成的W中的子空间。

前一种描述着重于将矩阵作为空间内的对象来看,而后一种描述强调的是矩阵所代表的线性变换。

错题

- 1.i 判断:矩阵A的行变换能够改变A的行之间的线性相关关系。

误解:F

正解:T。矩阵的行变换无法改变矩阵列之间的线性相关关系。 - 1.o 判断:若矩阵A和B有着相同的简化阶梯形,则RowA=RowB。

误解:F

正解:T。 简化过程实质上是什么?标乘和加法运算,空间的性质也是满足这两点的封闭性。那么对行进行这些运算不会改变行空间,也就是RowA=RowB。但是, ,想想看为什么? - 15.设A是 矩阵,B是 矩阵,且 ,证明:

证明:

ch5 特征值与特征向量 ‘线性代数及其应用笔记’

具体数学

5.1 特征向量与特征值

A为n维方阵,x为非零向量,若存在数 使 成立,则称 为A的特征值,x称为对应于 的特征向量。

定理 三角矩阵的主对角线的元素是其特征值。

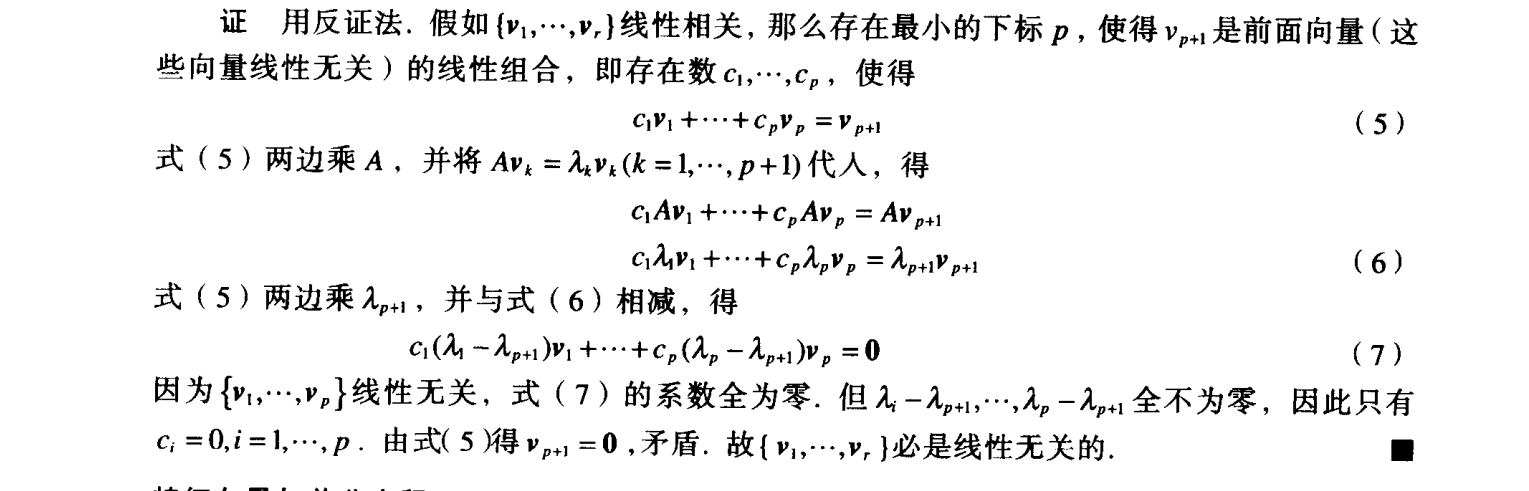

又一个定理 n维方阵A的各个特征向量组成的集合 线性无关。

证明: 23.png-128.6kB

23.png-128.6kB

特征向量和差分方程

对于方程 ,这个方差使用递归来表示x序列,下面我们找出x的显式解,也就是x不依赖A和序列前面的项,而是依赖初始项。利用 ,找出A的一个特征向量 并令

5.2 特征方程

求特征值的基本思想是利用行列式把含有两个未知数的方程 转化为只含有 的方程。

首先要原方程x有非平凡解,那么 就是不可逆矩阵,就是说 的行列式为0。

回想一下求行列式方法,利用倍加和交换将其转换为阶梯形,那么行列式等于主对角线乘积乘以 (r为行交换次数)。

那么很容易发现,阶梯形矩阵主对角线上的元素,如果可逆,那么都是主元,行列式不为0;若不可逆,那么主对角线上必有元素为0,则行列式为0。所以A可逆当且仅当行列式为不为0。再结合三角矩阵的主对角线的元素是其特征值,我们又可以得到可逆矩阵的又2条定理(天哪噜,好多定理了) :

A是n维方阵,A是可逆的当且仅当:

1. 0不是A的特征值

2. A的行列式不等于零。

顺便我们也来总结下行列式性质:

1. A可逆当且仅当

2.

3.

4. 若A是三角形矩阵,则detA是A对角线元素乘积

5. 对A做行倍加不改变行列式,做一次行交换行列式变符号,数乘一行后行列式等于原值乘以此数。

插完回顾,我们得到以下结论:

数 是n维方阵A的特征值得充要条件是 是特征方程 的根。

容易得出特征方程左边是n次多项式,称为A的特征多项式。

若特征多项式中 出现n次,则称特征值k有重数 n。

这里插一句,特征值允许有复根,称为复特征值,但是一般我们只考虑实特征根。

下面是特征值的一个用途,相似性

A,B都是n维方阵,若存在可逆矩阵P,使得 ,则称A相似于B,或A和B是相似的,把A变为 的变换称为相似变换。 相似矩阵有着相同的特征多项式,从而有相同的特征值(和重数)。(通过证明 得到)

5.3 对角化

利用分解式 ,我们能在k较大时快速算出 。D代表对角矩阵,容易得

那么容易得出

对角化定理

n维方阵A可对角化的充要条件是A有n个线性无关的特征向量。

换句话说,A可对角化当且仅当有足够特征向量形成 的基,我们称这样的基为特征向量基。

在证明过程中我们可以发现,A的对角矩阵D的主对角线元素即为A的特征值,P的列即为A的特征向量。

那么确定一个矩阵可以对角化之后我们看看如何对角化:

对角化步骤

1. 求出A的特征值

2. 求A的线性无关的特征向量

3. 用第2步得到的向量构造矩阵P

4. 用对应的特征值构造矩阵D

在求的时候我们可以看出一个可对角化的充分条件,就是n维矩阵有n个相异的特征值。n个相异的特征值能保证n个线性无关的特征向量。当相异特征值个数小于n时,只要每个特征值 的特征空间维数等于 的代数重数,那么也可以保证A可对角化。

这里加一个对角化和线性变换

原来是5.4的内容,但是加在这里更好一点

如果 。D为n维对角矩阵,若 的基B由P的列向量组成,那么D是变换x->Ax的B-矩阵。

5.4 特征向量与线性变换

线性变换矩阵

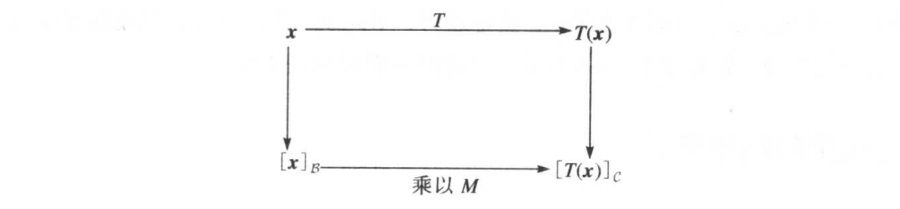

设V是n维向量空间,W是m维向量空间,T是V到W的线性变换,B/C分别是V/W的基。 那么有:

如果不能理解可以看这张图:

QQ图片20160602151226.png-23.4kB

QQ图片20160602151226.png-23.4kB 矩阵M是T的矩阵表示,称为T相对于基B和C的矩阵。就坐标向量而言,T对x的作用相当于用矩阵M左乘x。

V到V的线性变化

我们来看看基不变的情况,这时V=W,C=B,M就叫做T的B-矩阵,也就有

这里我们就是选定了B这组基(●'◡'●)嗯。

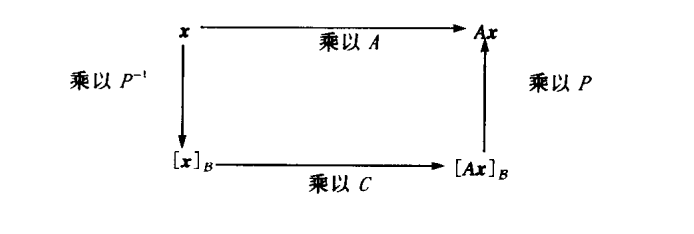

矩阵表示的相似性

如果 ,即A相似于C,若 的基B由P的列向量组成,那么C是变换x->Ax的B-矩阵。

0.png-13.4kB

0.png-13.4kB 5.5 复特征值*

通过复数的拓展,可以把之前的结论进行推广,开辟新领域,但是我觉得还是看看就好,用到之前没有太大必要深究。

注意一个,一般矩阵如果有复特征值/特征向量,特征值/向量往往是共轭的。即,a+bi和a-bi都是特征。

5.6 离散动力系统* 5.7微分方程中应用 *

注意几个概念

1. 吸引子 对于动力系统 ,所有轨迹趋向的点。

2. 鞍点 对于动力系统 ,在某些方向上吸引解,其他方向上又排斥解的点。

3. 基础解系 微分方程 一定存在含有n个线性无关函数的基础解集,使得每一个解都可以唯一地表示为这n个函数的线性组合。

4. 解耦 仅依赖于元素自身,而不依赖于各元素的组合。 例如函数的导数。

5.8 特征值的迭代估计*

因为在实际应用中,很难能精确得到特征值,但是幸运的是,一个较精确的近似值就可以达到满意的效果。

幂算法 适用于求矩阵A的主特征值(绝对值最大的特征值)

- 选择一个最大分量为1的初始向量

- 对

- a. 计算

- b. 设 是 中绝对值最大的分量

- c. 计算

- 几乎对所有选择的 ,序列{ }都近似于主特征值,而序列{ }近似于对应的特征向量

逆幂法 已知特征值的初步估计后用以对任一特征值近似估值。

错题

补充习题

1.l 判断:矩阵A的两个特征向量之和仍是A的特征向量

正解:错,只有两个对应于同一个特征值的特征向量的和才是。题目没看清就做了QAQ

1.v 判断:矩阵A,B均为N维可逆矩阵,则AB相似于BA

正解:对,因为存在 使

9 证明:当A的所有特征值都小于1时,I-A可逆。

正解: 反证法, 假设I-A不可逆

那么 有非零解,则有 ,则有特征值为1,与题设矛盾,所以I-A一定可逆。

心得拾遗

- 首先注意啦,相似性和行等价是完全不同的两回事,对矩阵做行变换通常会改变特征值。

- 注意甄别5.4中线性变换和4.7基变换的区别和联系。当5.4中B和C是同一空间V的基时,M就相当于4.7中坐标变换矩阵。Tips线性变换中注意①向量空间是否变化②向量空间是否是欧几里得空间( )③基是否变化

- 其实5.4这里有点不理解,为啥要把基变换和线性变换搅和到一起去呢?分别来算不是很清楚吗?

Update: 之前竟然没有认识到编者的用心,其实基变换和线性变换可以说是同源的。对于线性变换,我们可以用矩阵来表示,对向量b实施变换A,就用A乘b,得变换后为Ab。当 各列线性无关时, 可以表示一组基,那么将单位基度量的b转换到以 为基的坐标系中,用的操作也是左乘,即Ab就是b在新坐标系中的坐标。这里,变换是相对的,本质上讲,基变换和线性变换是一样的操作。那么不难发现,所谓的相似矩阵的真相是若两个矩阵相似,那么它们可能是同一个对象在不同坐标系中的描述。这里的对象可以是线性变换(矩阵本身表示变换),也可以是向量的组合(不是向量的集合,因为集合内对象无序)。 - 一个常见的误区就是,对特征向量的理解,我们平常所见的“求特征向量”,其实是求特征值对应的特征空间的基。特征空间里所有向量都是特征向量,对应每个特征值的特征向量都是无穷的,所以我们要求的是特征空间的基,有了基,只要随便

搞搞基搞个基的线性组合,就都是该特征值对应的特征向量。 注意,不同特征值对应的特征向量的线性组合可不是特征向量。 - 插播一个习题中的概念和结论,5.4的习题中提到矩阵的迹,记作tr(A),它表示矩阵主对角线元素之和,可以证明,矩阵的迹等于其特征值之和。

ch6 正交性和最小二乘法 ‘线性代数及其应用笔记’

具体数学

6.1 内积,长度和正交性

内积

如果u和v是 空间中的向量,可以将u和v作为 矩阵,我们将一个不加括号的实数,如 称为u和v的内积,并记作 。内积又称点积。

内积运算满足

- ,并且 的充要条件是

向量长度

向量v的长度(范数)是非负数

且有 。

将某向量除以自身长度的过程叫做单位化, ,u和v方向相同。

向量距离

u和v距离,

正交向量

两条直线几何上垂直当且仅当从u到v和从u到-v的距离相等。

那么容易得出 空间上向量互相垂直(或者说线性代数中的术语正交)的条件。

定义:如果 那么两个向量u和v正交。

正交充要条件(毕达哥拉斯定理)

正交补

如果向量z和 子空间W中任意向量都正交,则称z正交于W。与子空间W正交的向量z的全体组成集合称为W的正交补,记作 。

正交补有如下性质:

1. 向量x属于 的充要条件是x与W的任一向量都正交。

2. 是 的一个子空间

6.2 正交集

向量集合中任意两个不同向量都正交的集合叫做正交集。

若 是 空间中非零向量构成的正交集,那么S是线性无关集,因此构成所生成的子空间S的一组基。

把正交和基搅和到一起给出一个正交基的定义, 中子空间W的一个正交基是W的一个基,且是正交基。

之前已经有基了呀,为啥还要搞一个基,这是因为正交基比较优越,线性组合中的权值比较容易计算。(比如笛卡尔坐标基),它有这样的性质:假设 是 中子空间W正交基,那么对于W中每个 中的权值可以由

下面是一个几何解释:正交投影

对于 中一个非零向量u,对一个向量y进行分解使 ,其中 ,z和u正交。 称为y在u上的正交投影,z称为y垂直u的分量。 容易得到

定理

- 一个 矩阵U具有单位正交列向量的充要条件是

- 假设U是一个具有单位正交列的 矩阵,且x和y是 的向量 ,那么

其实就是说,单位正交列构成的矩阵U代表的变换保持长度和正交性。

哦哦对咯,如果U是方阵的话,显然U可逆, ,这样的U就叫做正交矩阵。

6.3 正交投影

我们把上面提到的正交分解拓展到 子空间。

正交分解定理

若W是 的一个子空间,那么 中每一个向量y可以唯一的表示为

此处 。

如果 是W的任意正交基,那么有

就称为y在W上的正交投影。

正交投影有一个性质,称为最佳逼近定理:

假设W是 一个子空间,y是 的任意向量, 是 在W上正交投影,那么 是W中最接近 的点,也就是对于任意异于 而又属于W的 ,

6.4 格拉姆-施密特方法

格拉姆-施密特方法是对 中任何非零子空间,构造(标准)正交基的简单算法。

步骤

对 中子空间的一个基 ,定义

QR分解

如果 矩阵A的列线性无关,那么A可以分解为A=QR,其中Q是一个 矩阵,其列形成Col A的一个标准正交基,R是一个 的上三角可逆矩阵且在对角线上的元素为正数。

其中的Q可以用格拉姆-施密特方法加上单位化求解,因为R可逆(6.4.19习题证明),所以其对角线上不可能为0,所以如果是负数的话可以可以通过行变换改变正负(同时相应改变Q的某些元素正负值),所以R的对角线上元素可以全为正数。

6.5 最小二乘问题

在求解方程组 时,解可能不存在但又需要求解,最好的 办法是去去寻找使 尽可能接近 的 。一般的最小二乘问题就是去找出使 尽量小的 。

定义

如果 矩阵A和向量b属于 , 的最小二乘解是 中的 使得

成立。易知无论如何选择x,Ax都属于列空间ColA。所以我们可以应用6.3中的最佳逼近定理于ColA空间。

那么就有 ,然后就可以解出 了。可是这样还要求b的投影好麻烦,这里有个等价表述(证明见p359):

定理 方程 的最小二乘解集合法方程 的非空解集一致。呀,太棒了,那就不用管要先求正交基啊再求b的投影巴拉巴拉,直接解法方程就好啦。解方程有时会发现会有多个解,咦?正交投影应该是唯一的啊,为啥会有多个解呢? -_-||你傻呀。。 是唯一的,但是 可以有好多解啊。

那啥时候只有一个解呢?

再一个定理 矩阵 可逆的充分必要条件是:A的列是线性无关的。在这种情况下,方程 有唯一的最小二乘解有时需要知道解的误差,即最小二乘误差:b到 的距离。

另一种算法,当我们发现 的列正交时,即 的列就是 的正交基,那么求 在 的正交投影很方便,那么我们可以把投影 算出来,然后求解方程

有时在求解 出现的小误差会导致 出现大误差,那么在A的列线性无关情况下,我们利用QR分解可以更可靠的求出。

本节最后一个定理啦 对于有着线性无关列的矩阵A,对A做QR分解 (忘了QR分解,滚回去看),那么对于每一个 , 都有唯一的最小二乘解

6.6 线性模型中的应用

最小二乘直线

对于线性方程 ,给定点列,确定参数,使直线尽可能靠近这些点。(●▼●;),不就是线性回归嘛。。)

至于度量接近程度,最常见的选择是余差平方之和(因为算起来简单)。那么我们将方程写为

这里好像很熟悉。。这不就是前一节里的 的最小二乘解嘛,换了个马甲而已。那么这里求(线性)回归系数 就可以用到之前的方法了。

一般线性模型

引入余差向量 后将方程记作

具有这种形式的方程就叫线性模型,一旦X和y被确定,使 最小化相当于之前找 最小二乘解。其他曲线

当数据拟合的曲线明显不是直线时,我们也可以用最小二乘拟合来拟合其他曲线,如三次幂的话如下:

00.png-22.6kB

多重回归

若一个实验包含两个(或多个)独立变量和一个函数变量例如:

当然也可以是高次幂的,这里以u和v的一次幂为例。 这种最小二乘拟合称为趋势曲面。

一般形式为

这中问题和前面的简单回归模型有着一样的抽象形式,如下:55.png-32.5kB

无论多少变量,我们依然可以得到最小二乘解6.7 内积空间

这一章其实就是把之前的内容从 拓展到内积空间啦。

内积内积是一个函数,对于向量空间中每一对向量u,v,都存在一个实数满足下面公理:

1.

2.

3.

4.

一个含有上面内积的向量空间称之为内积空间长度/距离/正交性

长度(范数)

距离

正交

格拉姆-施密特方法

同样,内积空间也存在正交基,也可以用格拉姆-施密特方法求得。

可以先将问题转化为 ,比如有限离散值下的 问题。

步骤其实是一样的,先取第一个向量单位化,再取后面的向量减去之前它在获得向量组成的子空间上的投影并单位化,直到求出所有基。

内积空间的最佳逼近

同样,对V平面的正交投影满足最佳逼近。两个不等式

- 柯西-施瓦茨不等式

两向量内积绝对值小于其距离积。- 三角不等式

6.8 内积空间应用*

就简单介绍下加权最小二乘法

对于最小二乘逼近解 ,其误差可以记作 或者简记 。有时各个分量的权值不一样,记权值为 ,记对角线为权值的对角矩阵为W。那么就可以解出方程

。那么其法方程就是

好题解析

6.5.19-21 证明A的列向量线性无关的充要条件是 可逆。

解:

补充习题1.n 判断:U具有单位正交列,那么

解: 错误False。 题目没看清就下笔,同时也说明数学直觉还不够敏锐。

复习一下吧,U具有单位正交列,那么 .

如果U的列构成W的单位正交基,那么y在W上投影为补充习题1.p 判断:方阵具有单位正交列,那它也具有单位正交行

解: 对 True。 是方阵呀。矩阵具有单位正交列的充要条件是上面的 。

具有单位正交列的方阵有 。 那么 ,也就是说矩阵的转置具有单位正交列,那么矩阵便有单位正交行。ch7 对称矩阵和二次型 '线性代数及其应用笔记'

具体数学

7.1 对称矩阵的对角化

对称矩阵 满足 的矩阵。 好了我们回忆下5.3节中对角化的内容并将其应用到对称矩阵上,并引入如下定理:

定理 如果A是对称矩阵,那么不同特征空间的任意两个特征向量是正交的。如果存在正交矩阵P(满足 )和一个对角矩阵D使得 ,我们称A 可正交对角化。

显然对称矩阵可正交对角化,那么我们从反面来证可以得到这个定理:A可正交对角化的充要条件是A是对称矩阵。

(对称矩阵好厉害,不仅可以对角化还能正交对角化)这里我们求出特征向量后可能会发现某个特征空间的特征向量并不正交,不要着急,这不代表该矩阵不能正交对角化,我们可以看看能不能求出该特征空间的正交基,然后将其作为P的列,然后就可以得到结果了哦。

谱定理

A的特征值的集合有时称为A的谱(一个矩阵你摆什么谱(╯‵□′)╯︵┴─┴)对称矩阵的谱定理

一个n维对称矩阵具有下面特征

1. 具有n个实特征值,包含重复的特征值

2. 对每一个特征值,对应特征子空间的维数等于 作为特征方程的重数

3. 特征空间互相正交,这种正交性是在特征向量对应不同特征值的意义下成立的

4. 可正交对角化谱分解 其中u是特征向量, 是特征值。

7.2 二次型

上的二次型是一个定义在 上的函数,它在向量x处的值可由表达式 计算,此处A是一个n维对称矩阵,矩阵A称为关于二次型的矩阵。

一个简单的二次型例子,向量和其范数平方的映射 。

若x表示 中的向量变量,那么变量代换如 ,此处P是可逆矩阵且y是 的一个新变量。这里P的列可确定 的一个基,y是相对该基x的坐标向量。

用变量代换来处理二次型则

利用变量代换我们可以将二次型变为没有交叉项的二次型(即二次型对应矩阵是对角矩阵)。

主轴定理

设A是一个 对称矩阵,那么存在一个正交变量变换 ,它将二次型 变换为不含交叉项的二次型 。其中的P就成为二次型的主轴。

分类,一个二次型Q是

1. 正定的,如果对所有 ,有 ,这时所有特征值都是正的

2. 负定的,如果对所有 ,有 ,这时所有特征值都是负的

3. 不定的,如果 既有正值又有负值,特征值正负不定用这个可以来分类矩阵,例如正定矩阵就是其二次型为正定的对称矩阵。

7.3 条件优化

这里条件优化指的是寻找一个特定集合内使二次型 取最大值和最小值的 。

定理1 若A是对称矩阵,m是A最小特征值,M是A最大特征值,那么有

此时x分别取其对应的特征向量。

定理2

若A是对称矩阵,其正交对角化为 ,将对角矩阵D上的元素按大到小排列,并对应重排特征向量,那么对于 时,在以下限制条件下

那么 的最大值是 ,在 时取到。7.4 奇异值分解

如果A是 矩阵,那么 是对称矩阵且可以正交对角化,让 是 的单位正交基且构成 的特征向量, 是对应特征值,那么有

的特征值的平方根为奇异值,也就是向量 的长度( 是 的单位化的特征向量),记作 。定理 若 是包含 的特征向量的单位正交基,且以及按照其特征值由大到小重排。假若A有r个非零奇异值,那么 是ColA的一个正交基,且rankA=r。

上面这个定理可以把任意y用以 特征向量为基的坐标表示,SVD 奇异值分解

首先定义 分块矩阵

其中D是一个r*r的对角矩阵,r不超过m和n的最小值。

设A是秩为r的 矩阵,那么存在一个类似上面的矩阵,此处D的对角线元素是A的r个非零奇异值,并且存在一个 正交矩阵U和一个 矩阵V使得 ,分解中U的列称为A的左奇异向量,V的列称为A的右奇异向量。

可以证明U的列就是ColA的单位正交基,而V的列是A的特征向量基(单位化,不足n列用0补齐)。

下面具体说下SVD怎么做,把大象关冰箱总共分三步来:

1. 将 正交对角化 就是求特征值和特征向量

2. 求 ,将前面的特征值降序排列,并对应调动他们的特征向量形成V,对特征值进行算数平方运算形成 的对角元素。

3. 构造U。对非零奇异值对应的 ,计算 并单位化并用找到和这些列正交并能使U的列为基的列补满m列就构成了U。有了上面这些之后,我们可以得到可逆矩阵定理的最后部分

u.

v.

w.

x. A有n个非零的奇异值7.5 图像处理和统计学中应用(主成分析法)

简单回顾一下

均值

令 ,则平均偏差形式

协方差矩阵 ,S的对角线元素 就是观测值的各个量的方差,数据总方差指S中对角线上方差的总和。S中i行j列的元素 称为 和 的协方差,如果该元素为0,则统计学上称 和 无关。如果大部分变量无关,即协方差矩阵几乎是对角矩阵,那么多变量数据分析就可以简化。主成分分析

先将数据变换为平均偏差形式X,主成分分析的目标是找打一个正交矩阵P,确定一个变量代换 ,且新的变量 两两无关,整理后的方差具有递减顺序。

S是X的协方差,不难发现Y的协方差是 ,令D为由S特征值由大到小构成的对角矩阵,那么有 。协方差矩阵S的单位特征向量 就称为数据的主成分,其中最大特征值对应的特征向量称为第一主成分,第二大特征值对应的称为第二主成分。

那么我们可以用主成分 来确定新变量 ,这种分析方法可以进行多变量数据的降维,例如,第一成分在总方差的百分比是93.5%,第二成分为5.3%,第三成分是1.2%,那么我们可以只去第一和第二主成分来实现降维。

心得拾遗

二次型是个啥? 原则上来讲,它也是个函数,就和行列式一样,但是行列式只是对矩阵内的元素进行操作的函数,二次型则是将矩阵元素的线性运算作为多项式的系数,这里矩阵都是确定的,而其自变量是该矩阵向量空间内的一个向量。

奇异值分解有个值得注意的地方,设A的秩为r,那么V的前r列为A的行空间的基,后面的列为A的解空间的基,U的前r列为A的列空间的基,后面的列为A的转置的解空间。好题摘录

- 补充习题1.k 判断:一个正定二次型可以通过一个合适的变量变换 变为负定二次型,其中P是正交矩阵。

错误。显然,对函数因变量的取值变换不会改变函数的值域。

补充习题 1.n 判断:如果U是m行n列且列正交的矩阵,那么 是x在ColU上的正交投影。

错误。虽说U是列正交的,但是它既不是基,也没有单位化。可以由6.3内容得知命题错误。

补充习题9 证明:

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 陆陆自习室!评论本地搜索